I big data nella catena di fornitura permettono di creare strategie innovative che aiutano le aziende a favorire le operazioni logistiche. Analizzando tutti i dati che vengono generati nei propri magazzini, le aziende possono identificare opportunità di miglioramento e prendere decisioni strategiche per il business.

La diffusione dei dispositivi connessi a Internet si è moltiplicata negli ultimi cinque anni. Uno studio della società di consulenza International Data Corporation suggerisce che entro il 2025 ci saranno più di 41 miliardi di dispositivi intelligenti in tutto il mondo: si prevede che il numero totale di dispositivi produrrà più di 79,4 zettabyte di dati nel 2025.

La crescita esponenziale del volume di dati generati (conosciuto con l’anglicismo big data) presenta un’opportunità unica per migliorare i cicli operativi e il processo decisionale nelle organizzazioni. Secondo le dichiarazioni della società di consulenza tecnologica Gartner: "I big data sono risorse informative ad alto volume, alta velocità o alta varietà che richiedono modi economici e innovativi di elaborare le informazioni per consentire una migliore comprensione, il processo decisionale e l'automazione dei processi”.

L'analisi dei big data facilita l'estrazione di informazioni utili da grandi volumi di dati. Per segmentare e trasformare i dati, di recente è emersa un'ampia gamma di tecnologie per i big data, in grado di raccogliere e gestire un enorme volume di informazioni che sarebbe impossibile analizzare con i software tradizionali.

La tecnologia dei big data viene oggi applicata in tutti i tipi di aziende e settori, dai reparti di produzione per ottimizzare le prestazioni al marketing per segmentare il mercato e ottenere risultati ottimali.

Perché i big data sono fondamentali per il business?

Con l'analisi dei big data, le aziende possono monitorare ed elaborare la grande quantità di dati prodotti nella propria attività per identificare nuove opportunità.

Secondo lo studio Big data analytics capabilities and knowledge management: impact on firm performance, dell’Università di Torino: "L’analisi dei big data garantisce che i dati possano essere analizzati e categorizzati in informazioni utili per le aziende e trasformati in processi decisionali efficienti, aumentando così le prestazioni”.

È proprio nel processo decisionale aziendale che i big data iniziano a fare la differenza. Una ricerca multidisciplinare della Anderson School of Management (Stati Uniti) e del College of Economics and Management (Cina) conferma il ruolo strategico dei big data nelle imprese: "I nostri risultati empirici dimostrano che l'uso dell’analisi dei big data ha un impatto positivo sulla qualità del processo decisionale." Gli autori dello studio, pubblicato sulla rivista accademica Technological Forecasting and Social Change, sottolineano il potenziale dell’analisi dei big data per migliorare la competitività delle imprese. "Le aziende non devono solo promuovere i big data nelle loro attività commerciali, ma anche aumentare la loro capacità di analizzare questi dati, il che migliorerà la qualità del loro processo decisionale e le aiuterà a ottenere un vantaggio competitivo”.

‘Big data’ nella supply chain

I big data aprono un enorme orizzonte di opportunità per i leader della supply chain. Secondo un rapporto di Ernest & Young, il 61% dei dirigenti intervistati prevede di adottare l’analisi dei big data nei prossimi tre anni, mentre il 33% sta già sperimentando o ha implementato strumenti di questo tipo in alcune aree della propria supply chain.

L'analisi dei dati può portare benefici durante la produzione, lo stoccaggio, il trasporto e la distribuzione delle merci. Nella rivista accademica Big data analytics in supply chain management, i ricercatori della Western Illinois University (Stati Uniti) affermano: "L'analisi dei big data nella gestione della supply chain offre molti vantaggi, come la possibilità di prevedere in modo ottimale la domanda e l'offerta, di analizzare le mutevoli preferenze dei clienti o di rafforzare la visibilità della supply chain, ma pone anche nuove sfide per le organizzazioni”.

Con gli strumenti dei big data, vengono implementati metodi analitici per promuovere un processo decisionale informato nella catena di approvvigionamento. "L'analisi dei big data è emersa come un mezzo per fare previsioni più accurate che riflettono meglio le esigenze dei clienti, facilitano la valutazione delle prestazioni della catena di approvvigionamento, aumentano l'efficienza, riducono i tempi di reazione e supportano la valutazione dei rischi", sostengono i ricercatori del Concordia Institute for Information Systems Engineering (Canada).

Supply Chain Business Intelligence: i ‘big data’ applicati al magazzino

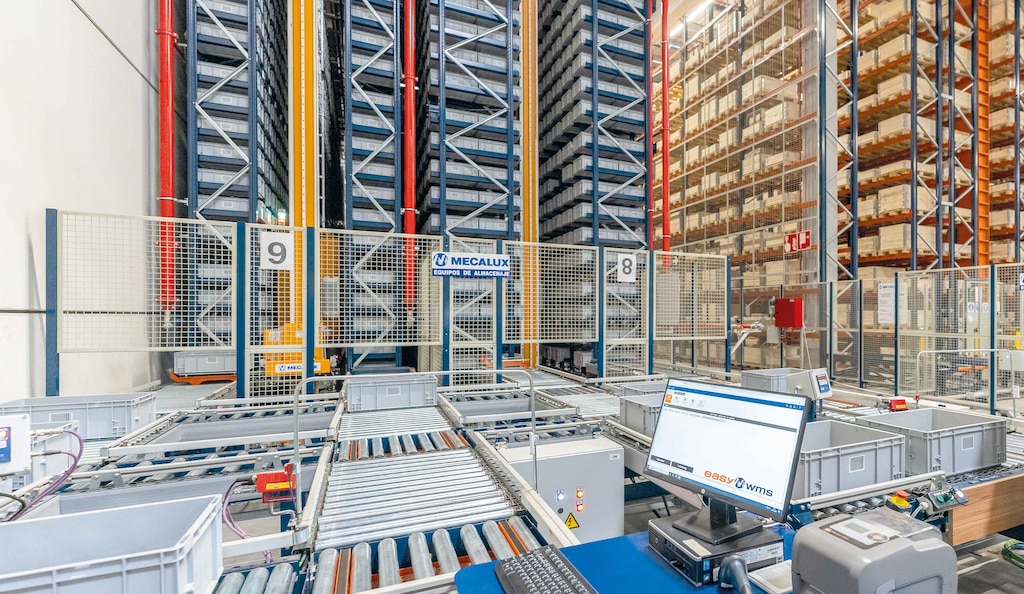

La digitalizzazione della logistica sta portando all'utilizzo di dispositivi in rete che generano una grande quantità di dati. Per facilitarne l'analisi e l'interpretazione, Mecalux ha sviluppato Supply Chain Business Intelligence, una funzionalità avanzata del software di gestione magazzino Easy WMS che segmenta e struttura i dati provenienti da qualsiasi installazione.

Trasformando la grande quantità di dati di magazzino in informazioni utili, il Responsabile della Logistica può prendere decisioni con maggiore facilità e precisione. Il modulo Supply Chain Business Intelligence ordina i dati in indicatori che mostrano in tempo reale le prestazioni operative e un'analisi storica delle prestazioni dell’installazione.

Il software incorpora pannelli di controllo e grafici con informazioni di base sull'impianto, come la percentuale di articoli in magazzino o le linee preparate. Il programma crea anche indicatori di performance personalizzabili in base alle esigenze di ciascun Responsabile della Logistica.

Supply Chain Business Intelligence favorisce una logistica flessibile e produttiva che si adatta alle necessità delle aziende. Ad esempio, l'azienda di prodotti per l'imballaggio e l'etichettatura Intermark ha dotato il suo magazzino del modulo analitico avanzato di Mecalux per il monitoraggio completo delle operazioni logistiche. “Il modulo mostra come si svolgono i processi e ci aiuta ad apportare miglioramenti strategici sulla base delle prestazioni delle operazioni quotidiane. Il nostro mercato è molto dinamico e le esigenze dei nostri clienti cambiano rapidamente, costringendoci a trasformare la nostra attività per soddisfare le mutevoli richieste dei clienti. Grazie a questo modulo, ora disponiamo di informazioni basate sui dati per proporre modifiche volte a migliorare la nostra logistica", spiega Juan Pablo Calvo, Direttore Generale di Intermark.

L'analisi dei big data fornisce inoltre alle aziende dati affidabili e oggettivi per modificare e ottimizzare i processi. "Easy WMS si adatta come un guanto alle particolarità della nostra attività. Con questo nuovo sistema, possiamo conoscere la disponibilità delle referenze e fare un inventario in tempo reale”, afferma James Hansen, Vicepresidente Esecutivo di Yamazen negli Stati Uniti. Il rivenditore di macchine utensili utilizza il modulo Supply Chain Business Intelligence per interrogare e analizzare il rendimento delle operazioni in magazzino.

Mecalux ha implementato il modulo Supply Chain Business Intelligence in strutture logistiche di tutto il mondo e per aziende di diversi settori. Con questa tecnologia, le aziende applicano i big data nei loro magazzini con l'obiettivo di controllare tutto ciò che accade nella supply chain.

Il potere dei dati guida la logistica

L’analisi dei big data è molto utile in tutte le industrie ma, in particolare nel settore logistico, risulta indispensabile. La grande quantità di dati generati nei magazzini ha un enorme potenziale per supportare il processo decisionale strategico.

Le aziende si affidano alla tecnologia per interpretare la colossale quantità di dati prodotti quotidianamente in diverse aree aziendali. L'analisi dei big data apre le porte a nuove opportunità di miglioramento, come l'ottimizzazione delle operazioni logistiche, la pianificazione degli investimenti futuri o il lancio di nuovi prodotti o progetti.

‘Big data’: una rivoluzione in ascesa

Nel 1997, i ricercatori della NASA Michael Cox e David Ellsworth hanno introdotto il concetto di big data nel documento Application-controlled demand paging for out-of-core visualisation. "La visualizzazione dei processi è una sfida interessante per i sistemi informatici: l’insieme di dati sono spesso di grandi dimensioni e mettono a dura prova la capacità della memoria principale, del disco locale e persino del disco remoto. Lo chiamiamo il problema dei big data”.

Nei primi anni 2000, la democratizzazione di Internet ha iniziato ad aprire opportunità uniche per la raccolta e l'analisi dei dati. L'espansione dei portali di vendita online ha reso più facile per aziende come eBay o Amazon concentrarsi sull'analisi del comportamento dei clienti per aumentare il volume delle vendite. Successivamente, l'ascesa dei social network ha intensificato la necessità di strumenti per organizzare la grande quantità di dati non strutturati provenienti dal web. Tuttavia, l'avvento dell'Internet delle cose (IoT) e dell'apprendimento automatico ha incrementato l'uso di dispositivi connessi, moltiplicando le possibilità dei big data.

Sebbene gli strumenti di analisi dei big data abbiano già una solida esperienza, l'emergere di nuove tecnologie come il cloud computing apre nuove strade per sfruttare il potenziale dell'analisi dei dati e ottimizzare le prestazioni organizzative.

Le 5 V dei ‘big data’

I big data comprendono cinque dimensioni, note come le 5V:

- Volume: la grande quantità di informazioni provenienti da più fonti deve essere gestita attraverso nuove forme avanzate di gestione, utilizzo e archiviazione dei dati.

- Velocità: il flusso massiccio e costante di dati a un ritmo vertiginoso richiede strumenti di raccolta ed elaborazione agili per evitare l'obsolescenza di tutte le informazioni raccolte e analizzate.

- Varietà: gli strumenti di analisi dei big data non devono elaborare solo fonti scritte, ma anche immagini, dati informatici, audio, video, nonché tutti i tipi di contenuti presenti sui social media e sulle nuove piattaforme.

- Veridicità: l'analisi dei big data si confronta con la necessità di selezionare i dati veritieri per ulteriori analisi e di scartare le informazioni irrilevanti.

- Valore: se i dati raccolti sono stati selezionati e analizzati correttamente, le informazioni ottenute saranno di grande valore per l'organizzazione.